Estudantes são vítimas de pornografia falsa criada com IA nos EUA

Ao acordar em uma manhã de outubro, Ellis, uma adolescente de 14 anos do Texas, tinha várias chamadas perdidas e mensagens de texto com imagens dela nua que circulavam nas redes sociais.

As fotos falsas (baseadas em seu rosto real e um corpo nu sobreposto) haviam sido enviadas a colegas de sala que dificilmente poderiam imaginar o engano.

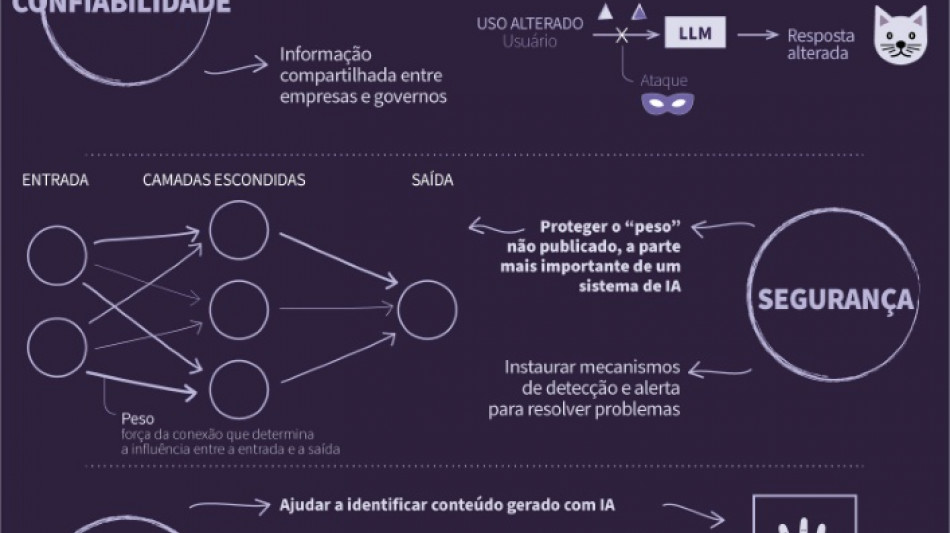

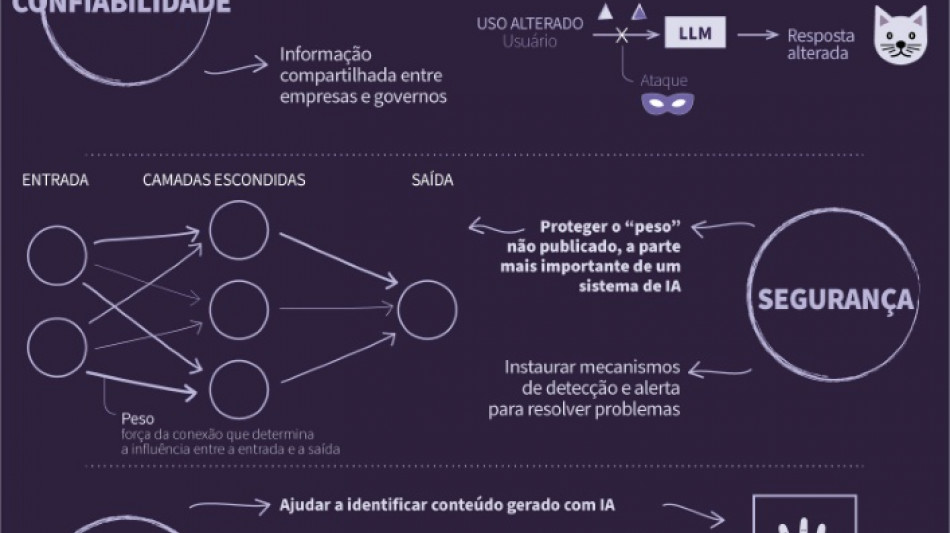

É que a Inteligência Artificial (IA) faz com que os chamados "deepfakes" (vídeos, imagens e áudios generativos que imitam a aparência e sons de uma pessoa) sejam cada vez mais realistas.

As imagens originais de Ellis e sua amiga, que também foi vítima, foram capturadas do Instagram, contou a estudante à AFP.

Outras colegas de sala também foram vítimas. Depois, as fotos foram compartilhadas pelo aplicativo Snapchat.

"Parecia real, como se os corpos (nus) parecessem corpos reais", disse a adolescente. "Lembrou que ficou muito, muito assustada".

Junto com o desenvolvimento da IA, cresce também a pornografia deepfake, com fotos e vídeos muito realistas que podem ser criados com um mínimo de esforço e dinheiro, o que provocou escândalos e casos de assédio em várias escolas dos Estados Unidos.

As autoridades tentam suprir a falta de legislação federal que proíba a prática.

"As meninas não paravam de chorar e chorar. Estão muito envergonhadas", declarou Anna McAdams, mãe de Ellis. "Não queriam ir para a escola".

- Um telefone e alguns dólares -

A prática se expandiu, embora não se saiba quanto. No final do mês, outro caso foi registrado em Nova Jersey.

"Isto ocorre com cada vez mais frequência", afirmou Dorota Mani, mãe de uma das vítimas, também de 14 anos.

Afirmou que pode haver deepfakes pornográficas na internet de uma pessoa mesmo que ela não saiba e que apenas são investigados os casos reportados pelas vítimas.

Segundo especialistas, a lei tardou em se atualizar em relação à tecnologia, apesar de já existirem casos de versões mais grosseiras de pornografia falsa há anos, frequentemente de pessoas famosas.

Agora, no entanto, qualquer pessoa com uma foto no Linkedin pode ser uma vítima.

Sabia-se "que seria utilizada desta forma", declarou à AFP Henry Farid, professor de informática na Universidade da Califórnia em Berkeley.

No mês passado, o presidente americano Joe Biden assinou um decreto sobre a IA que pede ao governo para criar barreiras "contra a produção de material de abuso sexual infantil e contra a produção de imagens íntimas não consensuais de indivíduos reais".

Em muitos casos, tem sido difícil encontrar os autores, mas isso não deveria impedir que as empresas de Inteligência Artificial e as plataformas das redes sociais prestassem contas, estima Farid.

O problema é que não existe uma lei federal que restrinja esta pornografia e apenas alguns estados aprovaram leis neste sentido.

"Embora se sobreponha a seu rosto, o corpo não é realmente seu", disse Renee Cummings, especialista em ética da IA.

Isto pode criar uma "contradição na lei", explicou à AFP a professora da Universidade de Virgínia, já que é possível argumentar que as leis existentes que proíbem a distribuição de fotografias sexuais não autorizadas não se aplicam às deepfakes.

Além disso, qualquer um que tiver "um 'smartphone' e alguns dólares" pode fazer as fotos.

A pornografia deepfake "pode destruir a vida de alguém", reconheceu Cummings, citando vítimas que sofrem com ansiedade, depressão e trastorno de estresse pós-traumático.

(K.Müller--BBZ)